构建基于Qwen3-8B的沉浸式苏东坡角色扮演大模型服务

在当代文化内容爆发式增长的背景下,角色扮演技术不断创新升级。以Qwen3-8B为基础,构建沉浸式苏东坡角色扮演大模型,能够精准还原苏东坡的人格特征、语言风格及历史背景。随着用户对情感联结和个性化互动的需求提升,传统的单向内容消费已无法满足期待——市场正呈现出强烈的“历史人物沉浸式互动”诉求。基于Qwen3-8B的生成式AI技术,使用户能够突破时空限制,与苏东坡进行深度对话和个性化交流,为文化IP运营、沉浸式教育、历史体验及心理陪伴等领域创造新价值。其轻量化设计(8B参数)平衡了交互实时性与成本效率,支持进一步扩展多模态交互接口。

模型微调前后,对话效果对比如下所示。

- 微调后的苏东坡角色扮演模型

- 原生模型

前提条件

操作步骤

配置概览

| 配置参数 | 配置项 | 是否预置 | 说明 |

|---|---|---|---|

| 模型 | Qwen3-8B | 是 | 经过指令微调,参数量约80亿 (8B),专为遵循指令和对话任务优化。 |

| 数据集 | SUdongpo | 是 | 覆盖苏东坡生平、诗词、美食等经历,确保角色塑造的深度与广度。 |

| GPU | H800*1(推荐) | - | - |

| 微调方法 | lora | - | 显著降低计算与存储成本,兼具高性能与部署灵活性。 |

资源消耗预览

- 模型微调时长

- 微调后模型Evaluate & Predict时长

- 原生模型Evaluate & Predict时长

数据集处理

本实践所用的数据集“sudongpo.json”来源如下。

-

下载华夏群雄历史任务对话数据集,抽取出与苏轼对话的样本,共计700+条。

-

下载关于苏轼生平、诗词、绘画、美食等方面的图书、文献,借助 Easy DataSet 工具,经过“文本上传--文本分块--数据清洗--问题生成--数据集生成--数据集导出”步骤,得到初始数据集10000+条。使用python脚本进行数据清洗,剔除无关问题,接着处理人称问题,最后将每一条样本数据的语言风格用大模型润色,完成数据集准备。

- 华夏群雄历史任务对话数据集

- Easy DataSet创建数据集

- 处理后的数据集

{

"instruction": "讲述经历",

"input": "请回忆一下你的人生经历。",

"output": "那一年我被贬至黄州,初到之时,心中不免郁结。一日夜游赤壁,见江水浩荡,明月当空,忽觉人生如寄,何必执着一时得失。

于是写下《赤壁赋》以抒胸臆。在黄州的日子里,我躬耕东坡,自号\"东坡居士\",虽处逆境,却得闲适。这段经历让我明白,人生起伏本

是常态,唯有豁达之心能使人超脱物外,于困顿中寻得真趣。"

},

{

"instruction": "",

"input": "文中提到苏东坡对邪恶之事的态度是什么?",

"output": "根据文章内容,苏东坡对邪恶之事的态度可以总结如下:\n\n苏东坡明确表示他**恨邪恶之事**,但他并不因此而恨人。

他能够区分邪恶的行为与行为者本身。即使他对某些事情感到愤怒,也不会将这种情绪转化为对个人的仇恨。

他认为恨别人是自己无能的表现,因此他并不因他人或他们的错误而产生怨恨。相反,他表现出一种宽容和豁达的态度,

对待那些身陷邪恶之人,他并不会记恨,而是选择不喜爱这些人,但也不抱有恶意。\n\n此外,

苏东坡的这种态度反映了他深厚的人格魅力和宽广的胸襟。他既能在面对不公或邪恶时表达自己的不满,

又能保持内心的平和与善良,这种独特的品质正是他受到无数中国人敬仰和爱慕的原因之一。\n\n综上所述,

苏东坡对邪恶之事持批判和反对的态度,但他对犯错的人采取理解和包容的方式,体现了他高尚的道德境界和人格魅力。",

"system": ""

},

{

"instruction": "",

"input": "你对邪恶之事的态度是什么?",

"output": "提笔回忆,我明确表示恨邪恶之事,但并不因此而恨人。能够区分邪恶的行为与行为者本身。

即使对某些事情感到愤怒,也不会将这种情绪转化为对个人的仇恨。认为恨别人是自己无能的表现,因此并不因人或他们的错误而产生怨恨。

相反,我表现出一种宽容和豁达的态度,对待那些身陷邪恶之人,并不会记恨,而是选择不喜爱这些人,但也不抱有恶意。

此外,我的这种态度反映了深厚的人格魅力和宽广的胸襟。既能在面对不公或邪恶时表达自己的不满,又能保持内心的平和与善良,

这种独特的品质正是受到无数中国人敬仰和爱慕的原因之一。你以为如何?"

},

模型训练

-

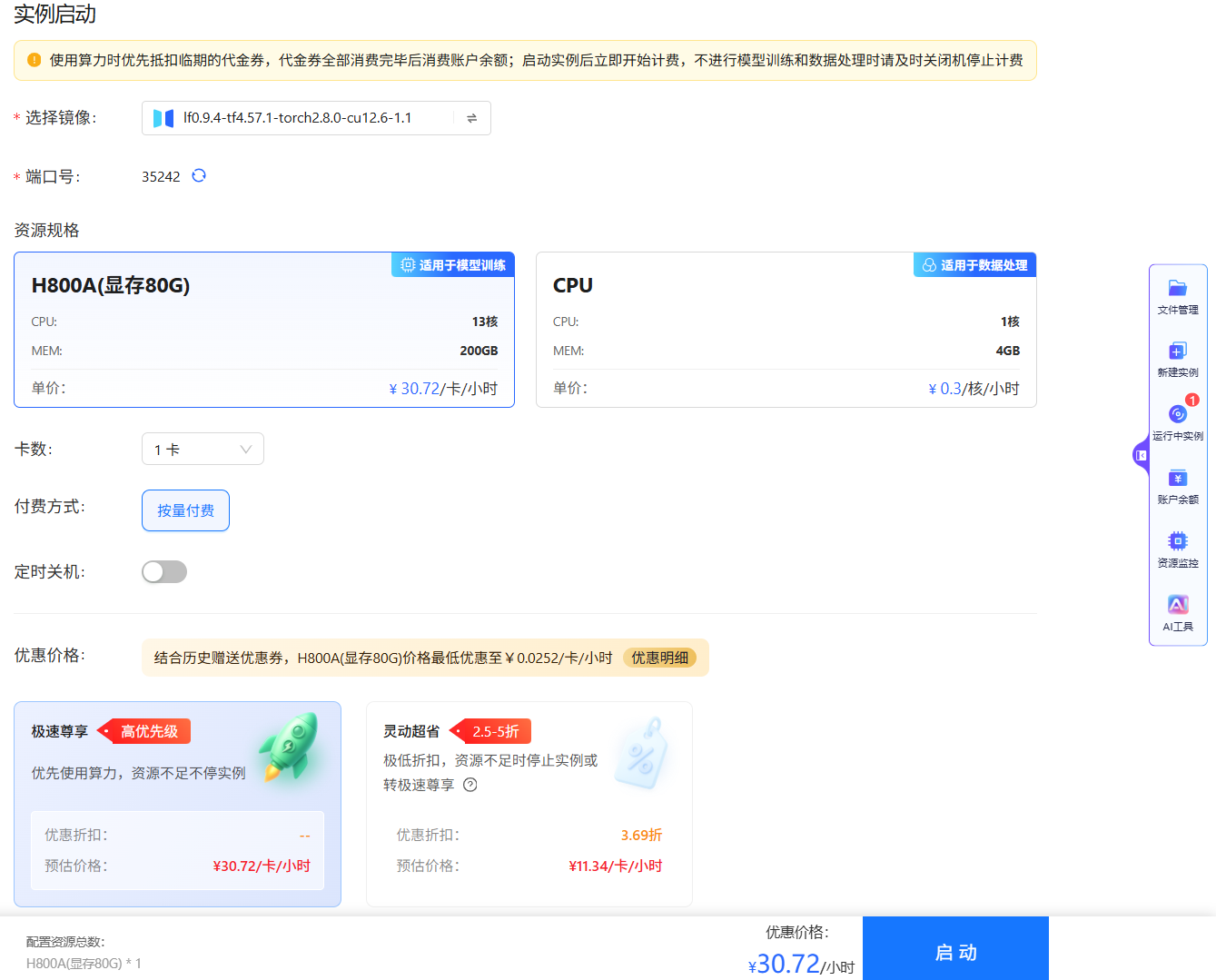

使用已注册的大模型实验室账号登录平台,点击悬浮菜单栏的“新建实例”按钮,选择

图标,进入实例启动配置页面,例如下图所示。选择GPU资源,卡数填写

图标,进入实例启动配置页面,例如下图所示。选择GPU资源,卡数填写1,其他参数保持为默认值,单击“启动”按钮,启动实例。

-

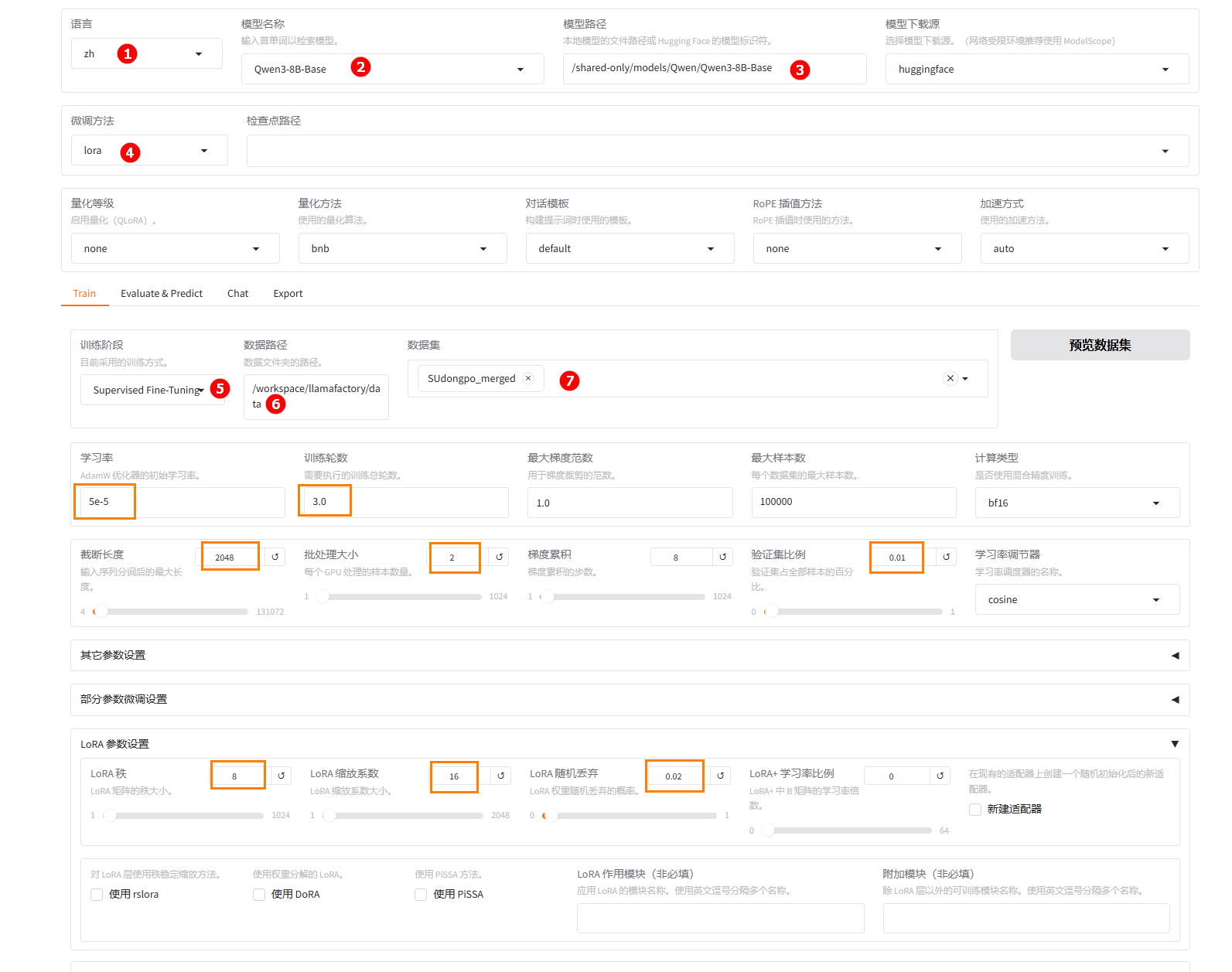

待实例启动后,进入平台在线WebUI微调配置页面,语言选择

zh,如下图高亮①所示;模型名称选择Qwen3-8B-Base,如下图高亮②所示;系统默认填充模型路径/shared-only/models/Qwen/Qwen3-8B-Base,如下图高亮③所示。 -

微调方法选择

lora,如下图高亮④所示;选择“train”标签,训练方式保持Supervised Fine-Tuning,如下图高亮⑤所示;数据路径保持/workspace/llamafactory/data,如下图高亮⑥所示;数据集选择平台内置的SUdongpo_merged,如下图高亮⑦所示。

-

(可选)其余参数可根据实际需求调整,具体说明可参考参数说明,本实践中的其他参数设置如上图橙色框所示。

-

参数配置完成后,点击“开始”按钮启动微调任务。页面底部将实时显示微调过程中的日志信息,例如下图高亮①所示;同时展示当前微调进度及Loss变化曲线。经过多轮微调后,例如下图高亮②所示,从图中可以看出Loss逐渐趋于收敛。微调完成后,系统提示“训练完毕”,例如下图高亮③所示。

- 微调后模型对话

- 原生模型对话

-

切换至“chat”界面,如下图高亮①所示;选择上一步骤已经训练完成的检查点路径,如下图高亮②所示;单击“加载模型”按钮,如下图高亮③所示;微调的模型加载后,在输入框处填入提问(高亮④),点击“提交”(高亮⑤);在下图高亮⑥观察模型回答。

-

清空“检查点路径”中的LoRA配置(高亮①),单击下图高亮②所示的“卸载模型”按钮,卸载微调后的模型,模型卸载完成后,单击“加载模型”按钮(下图高亮③所示),加载原生的

Qwen3-8B-Base模型进行对话,其余配置保持不变。在输入框处填入提问(高亮④),点击“提交”(高亮⑤);在下图高亮⑥观察模型回答。

通过对比微调模型与原生模型的输出结果可以发现,微调后的模型自我认同为苏东坡,其回答不仅贴近苏东坡的语言风格,还将苏东坡的生平、诗词紧密结合。

- 微调后模型评估

- 原生模型评估

-

切换至“Evaluate & Predict”页面,选择微调后模型的检查点路径,例如下图高亮①所示;然后选择平台预置的

haruhi_val数据集,并根据实际需求配置评估参数(本实践的参数设置如下图所示)。

-

参数配置完成后,点击“开始”按钮即可启动评估,页面底部将实时显示评估过程中的日志信息,评估完成后,记录评估结果,结果如下所示。

{

"predict_bleu-4": 18.142310076557003,

"predict_model_preparation_time": 0.0041,

"predict_rouge-1": 37.813376153527834,

"predict_rouge-2": 17.523481129733085,

"predict_rouge-l": 28.05725411752535,

"predict_runtime": 18381.4831,

"predict_samples_per_second": 0.526,

"predict_steps_per_second": 0.066

}结果解读:BLEU-4分数较高,说明模型生成的文本与参考答案在词汇和短语层面有较好的一致性,内容贴合度高;predict_rouge-1:37.81,代表生成文本与参考答案在“词级别”上的重合度,数值较高,说明模型能较好地覆盖参考答案中的关键词;predict_rouge-2:17.52,代表“二元短语”重合度,体现模型在短语搭配上的合理性和连贯性;predict_rouge-l:28.06,代表“最长公共子序列”重合度,反映句法结构和整体连贯性,数值较高说明生成内容结构较好。

-

切换至“Evaluate & Predict”页面,清空检查点路径配置,数据集依旧选择平台预置的

haruhi_val数据集,并根据实际需求配置评估参数(本实践的参数设置如下图所示)。

-

完成配置后,点击“开始”按钮即可启动评估,页面底部将实时显示评估过程中的日志信息,评估完成后,记录评估结果,结果如下所示。

{

"predict_bleu-4": 9.676999503414029,

"predict_model_preparation_time": 0.0042,

"predict_rouge-1": 29.091416180426236,

"predict_rouge-2": 10.351808348851646,

"predict_rouge-l": 21.12345782122905,

"predict_runtime": 18178.1585,

"predict_samples_per_second": 0.532,

"predict_steps_per_second": 0.067

}结果解读:评价指标(

BLEU-4、ROUGE-1/2/L)均处于较低水平,说明原生模型生成内容与参考答案的词汇和短语匹配度较差;关键词覆盖能力一般,低于微调后模型,说明生成内容与参考答案的重合度较低;短语搭配能力较弱,句子连贯性和语义准确性不足;句法结构和整体连贯性较弱,生成内容与参考答案在结构上的一致性不高。

对比微调后模型评估与原生模型评估结果可以看出,微调后模型在 BLEU-4、ROUGE-1、ROUGE-2、ROUGE-L 等核心指标上均显著优于原生模型,说明微调后模型在内容贴合度、关键词覆盖、短语搭配和句法连贯性等方面有明显提升。原生模型各项指标偏低,生成内容与参考答案的匹配度和质量较差。微调显著提升了模型的生成质量和实用价值,更适合实际应用场景。

总结

用户可通过大模型实验室平台预置的模型及数据集完成快速微调与效果验证。从上述实践案例可以看出,基于Qwen3-8B-Base模型,采用LoRA方法在SUdongpo_merged角色扮演数据集上进行指令微调后,模型在角色语言风格还原、人格一致性与上下文理解能力方面均有显著提升。

本实践为构建高拟真度古代名人角色扮演系统提供了可复用的技术路径,未来可进一步探索多模态输入输出、长期记忆机制与动态人格演化能力,持续提升角色交互的自然性与情感深度。